这是一个使用 PyTorch 实现的示例代码,用于训练多个分类器并确保它们的模型在未训练之前具有相同的参数: ```python import torch import torch.nn as nn import torch.optim as optim # 定义基础模型 base_model=nn.Sequential( nn.Linear(10, 20), nn.ReLU(), nn.Linear(20, 2) ) # 保存基础模型的权重 torch.save(base_model.state_dict(), 'base_model.pth') # 加载基础模型的权重,并将其用作初始权重 base_model_weights=torch.load('base_model.pth') model1=nn.Sequential( nn.Linear(10, 20), nn.ReLU(), nn.Linear(20, 2) ) model1.load_state_dict(base_model_weights) model2=nn.Sequential( nn.Linear(10, 20), nn.ReLU(), nn.Linear(20, 2) ) model2.load_state_dict(base_model_weights) # 定义损失函数和优化器 criterion=nn.CrossEntropyLoss() optimizer1=optim.SGD(model1.parameters(), lr=0.1) optimizer2=optim.SGD(model2.parameters(), lr=0.1) # 定义训练集和标签 train_data=torch.randn(100, 10) train_labels=torch.randint(2, (100,)) # 训练模型1 for epoch in range(10): optimizer1.zero_grad() output=model1(train_data) loss=criterion(output, train_labels) loss.backward() optimizer1.step() # 训练模型2 for epoch in range(10): optimizer2.zero_grad() output=model2(train_data) loss=criterion(output, train_labels) loss.backward() optimizer2.step() # 保存每个分类器的权重 torch.save(model1.state_dict(), 'model1.pth') torch.save(model2.state_dict(), 'model2.pth') ``` 在这个示例中,我们首先定义了一个基础模型 `base_model`,并将其权重保存在文件 `base_model.pth` 中。然后,我们加载这个权重,并将其用作模型1和模型2的初始权重。接下来,我们定义了损失函数和优化器,并使用相同的训练集和标签对每个模型进行了10个训练周期的训练。最后,我们保存了每个分类器的权重,以便以后使用。

创客课程开发的每个主题课程需要基于现实情景,设置学习探究任务,通过问题研究、任务...

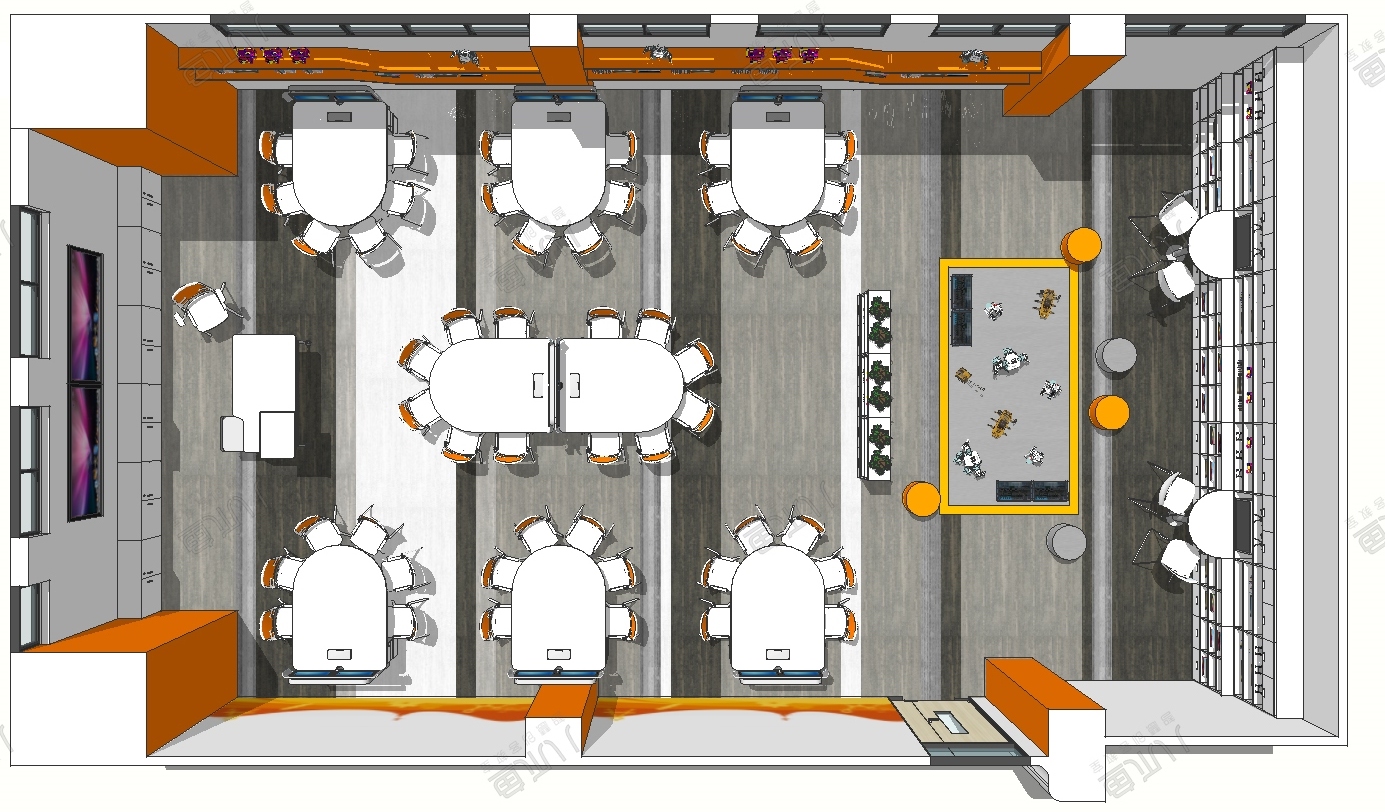

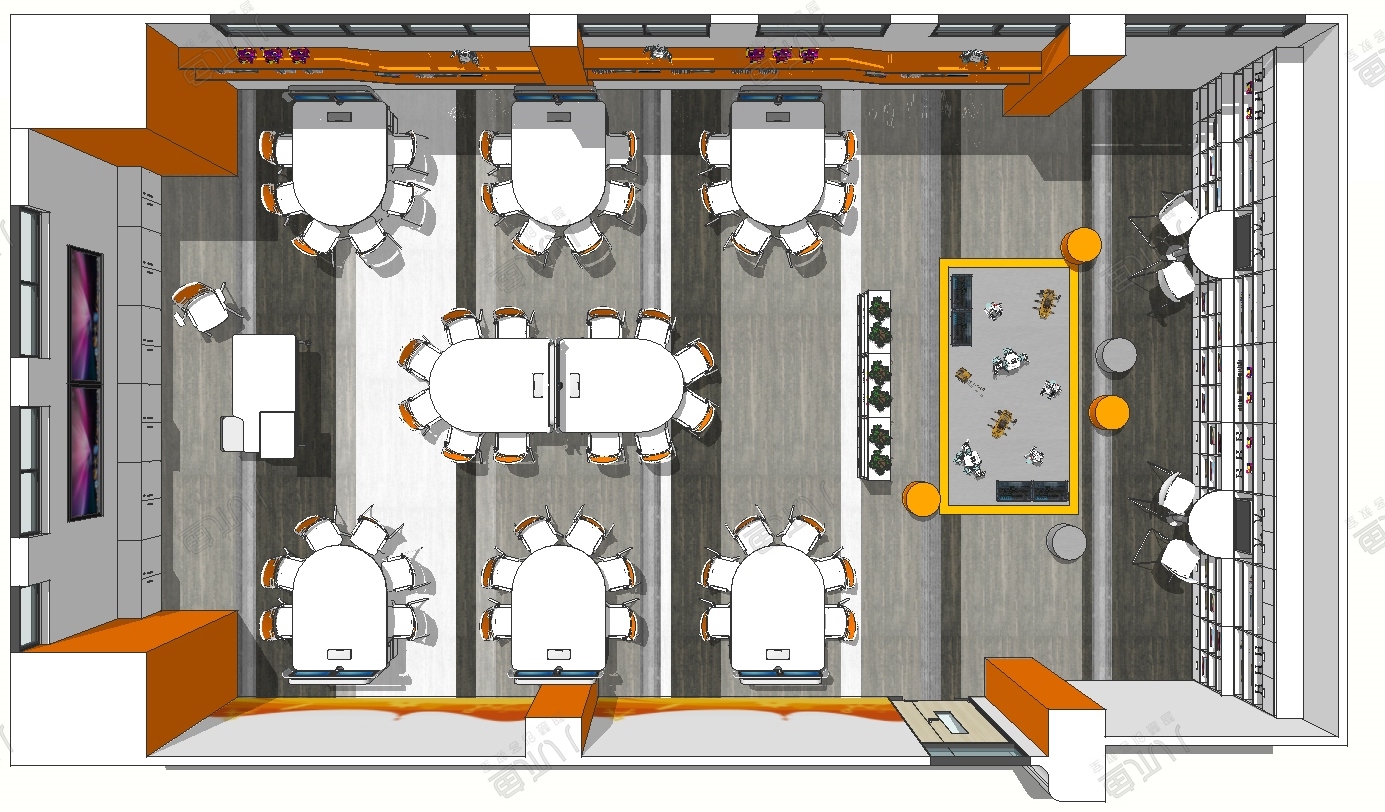

创客空间建设 能够给人们分享各种乐趣,通过电脑,技术,科学,艺术结合,设计创造一...

在了解创客教育之前,我们首先了解下何为创客。创客是一群喜欢或享受创新的人。创客跨...

STEAM教育是对传统教育的提升,它是基于自然学校方式的功能性框架,可以适合各类...