目录 讲解PyTorch优化GPU显存占用,避免out of memory 在深度学习任务中,对于复杂的神经网络和大规模的训练数据,显存占用成为一个常见的问题。当我们的模型和数据超出GPU显存的限制时,就会出现"out of memory"的错误。为了解决这个问题,我们可以采取一些优化策略来降低显存的占用。 Batch Size是指一次前向计算以及反向传播时所使用的样本数目。较大的Batch Size会占用更多的显存空间,但训练速度会更快。因此,在训练过程中我们可以根据显存的大小合理调整Batch Size。如果显存较小,可以降低Batch Size,反之则可以增大Batch Size。 PyTorch默认使用32位浮点数(float32)来表示权重和梯度,但较高的精度也会导致更大的显存占用。如果模型规模较大,可以尝试使用低精度的浮点数(如float16)来表示。注意,在使用低精度时需要注意数值溢出和梯度消失等问题。 梯度累积是一种优化策略,它可以减少一次迭代中的显存占用。通过累积梯度,我们可以将较大的Batch Size拆分为多个较小的Batch,并进行多次前向计算和反向传播。在更新参数时,我们对梯度进行累积平均,从而达到更新一次参数的效果。 在模型训练过程中,有时候我们会保存一些中间变量(如梯度、中间特征等),但这些变量会占用额外的显存空间。为了减少显存的占用,我们可以在使用完这些变量后,手动释放显存。 如果我们拥有多张GPU,可以使用数据并行处理来加速训练并减少单张显卡的负担。PyTorch提供了nn.DataParallel类来实现数据并行处理,使得我们可以将模型分布到多个GPU上进行训练。 通过上述这些优化策略,我们可以有效地降低GPU显存的占用,避免"out of memory"错误的发生。然而,在实际应用中仍需要根据具体情况进行试验和调整,以达到更好的性能和稳定性。 当应用PyTorch进行图像分类任务时,可以通过以下示例代码来展示如何优化GPU显存占用,避免"out of memory"错误。 在上述示例代码中,我们结合实际的图像分类任务,对PyTorch优化GPU显存占用进行了实现。通过使用合适的Batch Size、梯度累积和显存清理,可以有效避免显存溢出问题,并提高训练效率。但需要根据具体情况进行实验和调整,以获得最佳的性能和稳定性。 "GPU out of memory"是指在使用GPU进行深度学习任务时,由于GPU显存不足,导致无法分配足够的显存空间来存储模型、数据和计算中间结果,从而导致程序运行失败。当显存被完全占用时,GPU无法继续进行计算,就会抛出"out of memory"错误。 以下是导致GPU显存不足的一些常见原因:

创客课程开发的每个主题课程需要基于现实情景,设置学习探究任务,通过问题研究、任务...

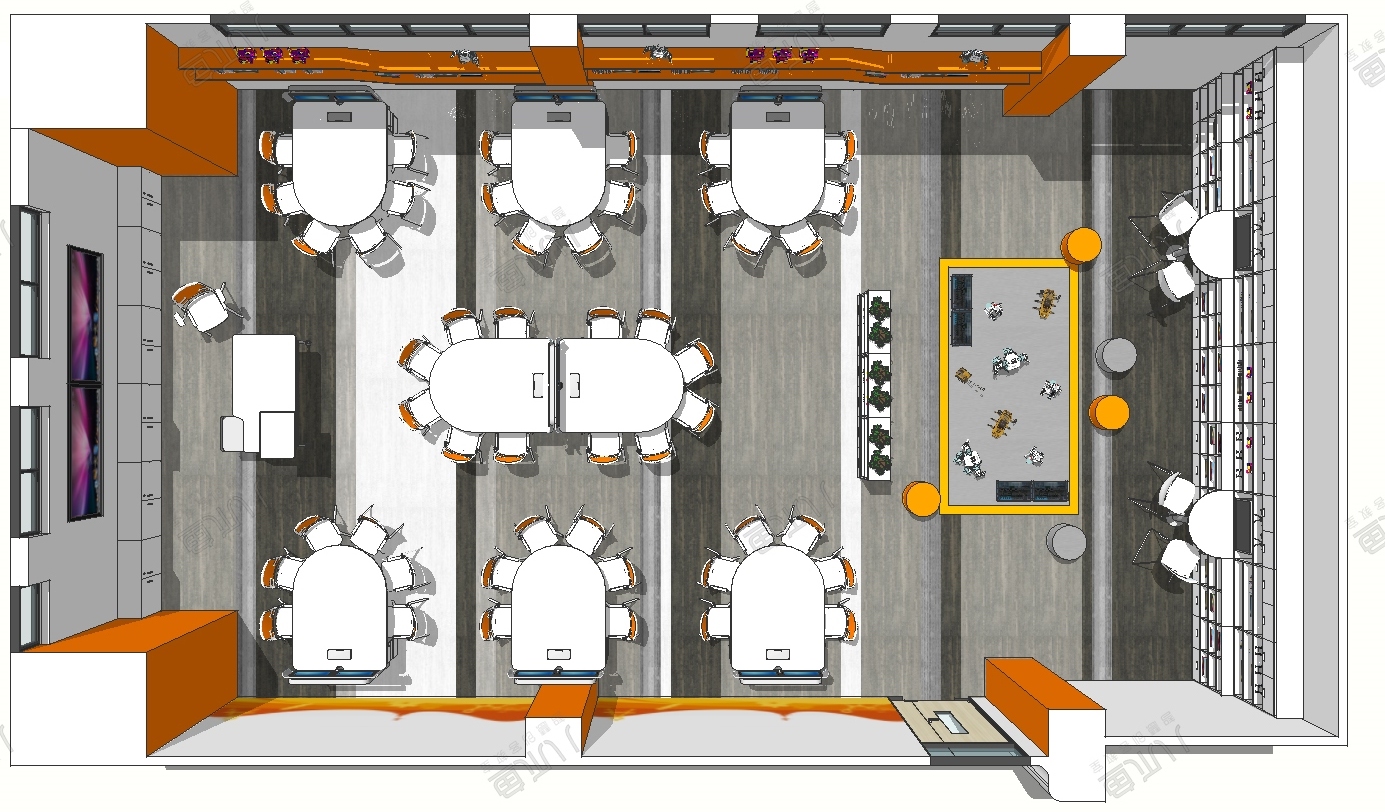

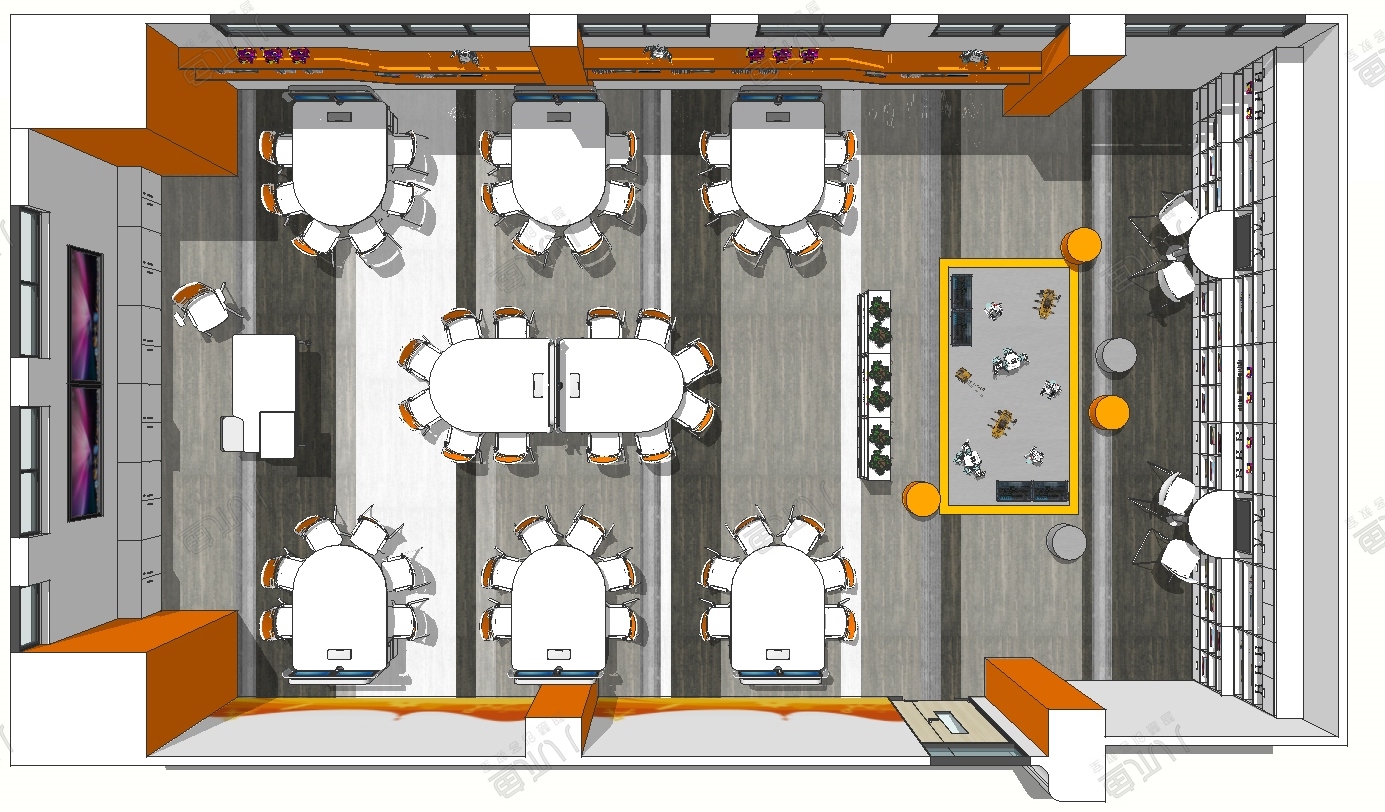

创客空间建设 能够给人们分享各种乐趣,通过电脑,技术,科学,艺术结合,设计创造一...

在了解创客教育之前,我们首先了解下何为创客。创客是一群喜欢或享受创新的人。创客跨...

STEAM教育是对传统教育的提升,它是基于自然学校方式的功能性框架,可以适合各类...